Sie wissen vielleicht bereits, dass Google über 200 Ranking-Faktoren in seinem Algorithmus einsetzt.

Aber welche sind das? Nun, Brian Dean hat sich die Mühe gemacht und alle bekannten Faktoren zusammen getragen.

Einige dieser Faktoren sind bewährt. Einige sind umstritten. Andere sind SEO-Nerd Spekulation. Aber sie sind alle hier.

Ich habe die Liste von Brian einfach mit dem Google Translater übersetzt , wer das original lesen möchte, kann das hier tun.

Domain-Faktoren

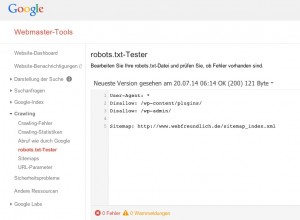

1 Domain Alter:. In diesem Video erklärt Matt Cutts, dass:

„Der Unterschied zwischen einer Domäne, ist sechs Monate alt Verse ein Jahr alt ist wirklich nicht so groß überhaupt.“.

In anderen Worten, sie verwenden Domain-Alter … aber es ist nicht sehr wichtig.

. 2 Schlagwort Erscheint in Top Level Domain: Hat die Boost, die es früher nicht geben, aber mit Ihrem Keyword in der Domain noch wirkt wie ein Signal Relevanz. Schließlich haben sie immer noch fett Schlüsselwörter, die in einem Domain-Namen angezeigt.

3 Stichwort als erste Wort im Domain:. Moz 2011 der Search Engine Ranking Factors Diskussionsteilnehmer einig, dass eine Domäne, die mit ihren Ziel Stichwort beginnt, hat einen Vorteil gegenüber Websites, die entweder nicht über das Stichwort in ihrer Domäne oder das Stichwort in die Mitte oder Ende ihrer Domäne.

4 Domain-Registrierung Länge:. Ein Google-Patent gibt:

„Wertvolle (legitimen)-Domänen sind oft für mehrere Jahre im Voraus bezahlt, während die Tür (illegitime)-Domänen sind nur selten für mehr als ein Jahr verwendet. Daher ist der Zeitpunkt, wenn eine Domäne ausläuft in der Zukunft als ein Faktor für die Vorhersage verwendet werden, die Legitimität eines Domain „.

5 Stichwort in Subdomain Name:. Tafel Moz ist auch vereinbart, dass ein Schlüsselwort in der Subdomain erscheinen steigert Rang,

6 Domain Geschichte:. Eine Seite mit flüchtigen Eigentum (über whois) oder mehrere Tropfen können Google zu sagen, „Reset“ die Geschichte des Ortes, negiert Links, die auf der Domäne.

. 7 Exact Match Domain: EMDs immer noch geben Ihnen einen Vorteil … wenn es ein Qualitäts Ort. Aber wenn das EMD geschieht, ein Low-Qualität vor Ort zu sein, ist es anfällig für die EMD Update:

8 Öffentliche vs Privat WhoIs:. Privat WHOIS-Informationen kann ein Zeichen von „etwas zu verbergen“ zu sein. Matt Cutts ist als Angabe bei Pubcon 2006 zitiert:

„… Wenn ich überprüfte die whois auf sie, sie alle hatten“ whois Privatsphäre Schutzdienst „auf sie. Das ist relativ ungewöhnlich. Mit … whois Privatsphäre eingeschaltet ist nicht automatisch schlecht, aber sobald man mehrere dieser Faktoren zusammen, sind Sie oft über eine ganz andere Art von Webmaster als der Kerl, der nur einen einzigen Standort oder so reden. “

. 9 bestraft WhoIs Besitzer: Wenn Google identifiziert eine bestimmte Person als Spammer macht es Sinn, dass sie anderen Seiten von dieser Person Besitz zu prüfen.

. 10. Land TLD-Erweiterung: Mit einem Country Code Top Level Domain (… Cn, pt, ca) hilft die Website Rang für das jeweilige Land … aber begrenzt der Site Fähigkeit, global zu ordnen.

Seite-Level-Faktoren

11 Stichwort im Title Tag:. Der Titel-Tag ist der zweitwichtigste Teil des Inhalts (neben dem Inhalt der Seite) einer Web-Seite und sendet eine starke On-Page-SEO-Signal daher.

. Title Tag 12 beginnt mit Schlagwort: Laut Moz Daten, Titel-Tags, die mit einem Schlüsselwort beginnt tendenziell besser als Titel-Tags mit dem Schlüsselwort am Ende des Tags durchführen:

. 13. Schlüsselwort in den Beschreibungen Tag: Ein weiterer Relevanz Signal. Nicht besonders jetzt wichtig, aber immer noch einen Unterschied macht.

. Wörter 14 Erscheint in H1 Tag: H1-Tags sind eine „zweite Titel-Tag“, die eine andere Relevanz Signal an Google sendet, so die Ergebnisse aus dieser Korrelationsstudie:

. Wörter 15 wird am häufigsten verwendet Phrase in Dokument: Nachdem ein Schlüsselwort mehr als alle anderen wahrscheinlich wirkt als Relevanz-Signal angezeigt.

Inhalt 16 Länge:. Inhalt mit mehr Worten kann eine breitere Bandbreite abdecken und wahrscheinlich kürzer oberflächlichen Artikel bevorzugt. SERPIQ festgestellt, dass die Länge des Inhalts mit SERP Position korreliert:

. 17. Keyword-Dichte: Obwohl es nicht so wichtig, wie es einmal war, ist immer noch etwas, Keyword-Dichte Google verwendet, um das Thema einer Webseite zu ermitteln. Aber über Bord gehen kann weh tun.

18 Latent Semantic Indexing Keywords im Content (LSI):. LSI Keywords helfen Suchmaschinen-Extrakt Bedeutung von Worten mit mehr als einer Bedeutung (Apple die Computer-Firma gegenüber dem Obst). Das Vorhandensein / Fehlen von LSI wahrscheinlich wirkt auch als Gehalt Qualitätssignal.

. LSI 19 Schlüsselwörter in Titel und Beschreibung Tags: Wie bei den Inhalt von Webseiten, LSI Keywords in Metatags Seite wahrscheinlich helfen Google erkennen zwischen Synonymen. Kann auch als Relevanz-Signal zu handeln.

. 20 Page Loading Drehzahl über HTML: Google und Bing zu verwenden Seite Ladegeschwindigkeit als Ranking-Faktor. Suchmaschinen können Ihre Website Geschwindigkeit ziemlich genau abschätzen, basierend auf einer Seite Code und Dateigröße.

. 21. Duplicate Content: Inhaltsgleichheit auf dem gleichen Gelände (auch leicht modifiziert) können Suchmaschinen-Sichtbarkeit einer Website negativ beeinflussen.

. 22. Rel = Canonical: Wenn richtig eingesetzt, kann die Verwendung dieses Tags von Google erwägen Seiten doppelte Inhalte zu verhindern.

. 23. Seite Loading Geschwindigkeit via Chrome: Google Chrome kann auch Benutzerdaten verwenden, um einen besseren Griff auf einer Seite Ladezeit zu bekommen, wie diese berücksichtigt Servergeschwindigkeit, CDN-Nutzung und andere nicht HTML-bezogene Website Geschwindigkeitssignale.

. 24. Bildoptimierung: Bilder auf-Seite zu senden Suchmaschinen wichtig Relevanz Signale durch ihre Dateiname, Alt-Text, Titel, Beschreibung und Beschriftung.

. 25. Aktualität des Content-Updates: Google Caffeine Update begünstigt vor kurzem aktualisierte Inhalte, vor allem für zeitkritische Suchanfragen. Hervorheben Bedeutung dieses Faktors, Google zeigt das Datum der letzten Aktualisierung einer Seite für bestimmte Seiten:

26 Magnitude von Content-Updates:. Die Bedeutung der Änderungen und Veränderungen ist auch eine Frische-Faktor. Hinzufügen oder Entfernen von ganzen Abschnitten ist ein wichtiges Update als Schalt um die Größenordnung von ein paar Worten.

27 Historische Updates-Seite. Updates: Wie oft wurde die Seite im Laufe der Zeit aktualisiert? Täglich, wöchentlich, alle 5 Jahre? Häufigkeit der Updates Seite spielen auch eine Rolle in der Frische.

28 Stichwort Prominenz:. Nachdem ein Schlüsselwort in den ersten 100-Worte der Inhalt einer Seite erscheinen scheint eine erhebliche Relevanz Signal sein.

29 Stichwort in H2, H3 Schlagwörter:. Nachdem Ihr Schlüsselwort als Bezeichnung in H2 oder H3-Format erscheinen kann eine andere Relevanz schwachen Signal.

30 Keyword-Wortfolge:. Eine genaue Übereinstimmung von Suchbegriff ein Suchender in den Inhalt einer Seite wird in der Regel Rang besser als das gleiche Keyword Phrase in einer anderen Reihenfolge. Zum Beispiel: Betrachten Sie eine Suche nach: „Katzen Rasur-Techniken“. Eine Seite für die Phrase „Katze Rasieren Techniken“ optimiert wird Rang besser als eine Seite für „Techniken für die Rasur eine Katze“ optimiert. Dies ist ein gutes Beispiel dafür, warum Keyword-Recherche ist wirklich, wirklich wichtig.

31 Outbound Link-Qualität:. Viele SEOs denken, dass die Verknüpfung aus, um Autorität Websites hilft Vertrauen zu senden Signale an Google.

32 Outbound Link. Thema: Laut Moz, Suchmaschinen können den Inhalt der Seiten, die Sie verlinken auf Relevanz als Signal zu verwenden. Zum Beispiel, wenn Sie eine Seite über Autos, die filmbezogene Seiten Links zu haben, dies zu sagen, dass Google Ihre Seite ist über den Film Cars, nicht das Auto.

33 Grammatik und Rechtschreibung:. Richtige Grammatik und Rechtschreibung ist ein Qualitätssignal, obwohl Cutts gab gemischte Nachrichten im Jahr 2011 auf, ob dies war wichtig.

. Syndicated 34 Inhalt: Ist der Inhalt auf der Seite Original? Wenn es abgekratzt oder von einer indizierten Seite kopiert es wird nicht so gut wie das Original Rang oder am Ende in ihre Supplemental Index.

35 Hilfreiche Zusatz Inhalt:. Laut einer jetzt-öffentliches Google-Rater Richtlinien Dokument, ist hilfreich zusätzliche Inhalte ein Indikator für die Qualität einer Seite (und damit Google-Ranking). Beispiele sind Währungsumrechnungskurse, Kreditzinsrechner und interaktive Rezepte.

. 36 Anzahl der ausgehenden Links: Zu viele dofollow OBLS kann „Leck“ PageRank, die Suche Sicht schaden.

. 37 Multimedia: Bilder, Videos und andere Multimedia-Elemente kann als Content-Qualitätssignal dienen.

38 Anzahl der internen Links, die zur Seite:. Die Anzahl der internen Links auf eine Seite zeigt seine Bedeutung im Vergleich zu anderen Seiten auf der Website.

. 39. Qualität der internen Links, die zur Seite: Interne Links von autorisierenden Seiten auf Domain haben eine stärkere Wirkung als Seiten mit keinen oder niedrigen PR.

. 40 Gebrochene Links: Zu viele defekte Links auf einer Seite kann ein Zeichen für eine vernachlässigt oder aufgegeben Website. Die Google-Richtlinien Rater Dokument verwendet defekte Links, wie man war, um die Qualität einer Homepage zu beurteilen.

. 41. Schwierigkeitsgrad: Es gibt keinen Zweifel, dass Google schätzt die Leseniveau von Webseiten:

Aber was sie mit diesen Informationen tun ist, zur Debatte. Einige sagen, dass eine grundlegende Leseniveau wird Ihre Seite Rang zu helfen, weil sie die Massen ansprechen. Allerdings Linchpin SEO entdeckt, dass Leseniveau war ein Faktor, der die Qualität von Websites Inhalte Mühlen getrennt.

42 Affiliate-Links:. Affiliate-Links selbst wahrscheinlich nicht verletzt Ihres Rankings. Aber wenn Sie zu viele haben, die Google-Algorithmus kann mehr Aufmerksamkeit auf andere Qualitätssignale zu zahlen, um sicherzustellen, dass Sie eine „dünne Partner-Website“ sind es nicht.

43 errors/W3C HTML-Validierung:. Viele HTML-Fehler oder schlampig Codierung kann ein Zeichen für eine schlechte Qualität Website. Während umstritten, viele in SEO denken, dass WC3 Validierung ist ein schwacher Signalqualität.

. Seite 44 Host-Domain Authority: Alle Dinge gleich eine Seite auf einer autorisierenden Domäne wird höher als eine Seite auf einer Domäne mit weniger Autorität.

45 Page PageRank:. Nicht perfekt korreliert. Aber im allgemeinen höhere PR-Seiten sind in der Regel besser als niedrige PR Seiten Rang.

46 URL-Länge:. Suchmaschine Blatt stellt fest, dass übermäßig lange URLs Suche Sichtbarkeit zu verletzen.

47 URL-Pfad:. Eine Seite näher an der Homepage kann es zu einer leichten Behörde Schub.

. Menschen 48 Redaktion: Obwohl nie bestätigt hat Google ein Patent für ein System, das menschliche Redakteure, um die SERPs beeinflussen können eingereicht.

49 Page Kategorie:. Die Kategorie der Seite erscheint ein Relevanz-Signal. Eine Seite, die Teil einer eng verwandten Kategorie ist sollte einen Schub Relevanz im Vergleich zu einer Seite, die unter einem nicht verwandten oder weniger verwandte Kategorie eingereicht zu bekommen.

. 50 WordPress Tags: Tags sind WordPress-spezifische Relevanz Signal. Nach Yoast.com:

„Der einzige Weg es Ihre SEO verbessert ist durch über ein Teil des Inhalts zu einem anderen, und insbesondere eine Gruppe von Stellen miteinander“

. Stichwort in 51 URL: Ein weiteres wichtiges Signal Relevanz.

52 URL-String:. Die Kategorien in der URL-Zeichenfolge werden von Google gelesen und kann eine thematische Signal, was eine Seite über bieten:

53 Hinweise und Quellen:. Unter Berufung auf Referenzen und Quellen, wie Forschungspapiere haben, kann ein Zeichen von Qualität sein. Die Google Qualitätsrichtlinien fest, dass Rezensenten sollte ein Auge für die Quellen, wenn man bestimmte Seiten: „Das ist ein Thema, wo Know-how und / oder maßgeblichen Quellen sind wichtig …“.

54 Bullets und Nummerierungen:. Aufzählungszeichen und nummerierte Listen helfen, brechen Sie Ihre Inhalte für die Leser, dass sie benutzerfreundlicher. Google wahrscheinlich stimmt zu und kann Inhalte mit Aufzählungszeichen und Nummern bevorzugen.

55 Vorrang der Seite Verzeichnis:. Die Priorität wird eine Seite über die sitemap.xml Datei kann beeinflussen Ranking gegeben.

. 56. Zu viele Outbound Links: Gerade aus der oben genannten Qualitäts Rater Dokument:

„Einige Seiten haben viel, viel zu viele Links, Verschleierung der Seite und lenkt von der Hauptinhalt“

. Menge von 57 Andere Keywords Page Ranks nach: Wenn die Seite zählt für mehrere andere Schlüsselwörter kann Google geben eine interne Qualitätszeichen.

Seite 58 Alter:. Obwohl Google bevorzugt frische Inhalte, eine ältere Seite, die regelmäßig aktualisiert wird möglicherweise eine neuere Seite zu übertreffen.

59 User Friendly Layout:. Unter Berufung auf die Google-Qualitätsrichtlinien Dokument noch einmal:

„Das Seitenlayout auf höchste Qualität Seiten macht die Hauptinhalt sofort sichtbar“

. 60 geparkte Domains: Ein Google-Update im Dezember 2011 verringerte Suche Sichtbarkeit der geparkten Domains.

. Nützlich 61 Inhalt: Wie von Backlinko Leser Jared Carrizales ausgeführt, kann Google zwischen „Qualität“ und „nützlich“ Inhalte zu unterscheiden.

Site-Ebene Faktoren

. Inhalt 62 schätzen und einzigartige Einblicke: Google hat erklärt, dass sie auf der Jagd nach Websites, die nichts Neues oder nützlich an den Tisch, vor allem dünne Affiliate-Websites mitbringen können.

63 Kontakt Seite:. Die oben erwähnte Google Qualitäts Dokument heißt es, dass sie Websites mit einem „angemessenen Betrag von Kontakt-Informationen“ bevorzugen. Vermeintliche Bonus, wenn Sie Ihre Kontaktinformationen entspricht Ihren whois-Info.

. Domänenvertrauens 64 / Trustrank: Site vertrauen – wie viele Links von Ihrer Website entfernt ist von sehr vertrauenswürdigen Websites Samen gemessen – ist ein Massively wichtiger Ranking-Faktor. Sie können mehr über Trustrank lesen Sie hier.

65 Website-Architektur:. Ein gut zusammengestellten Website-Architektur (vor allem ein Silo-Struktur) hilft Google thematisch organisieren Ihre Inhalte.

. Site Updates 66: Wie oft eine Seite aktualisiert wird – und vor allem, wenn neue Inhalte auf der Website hinzugefügt – ist eine Website weiten Frische-Faktor.

. 67 Anzahl der Seiten: Die Anzahl der Seiten eine Website hat ein schwaches Zeichen der Autorität. Zumindest eine große Website hilft unterscheiden ihn von dünnen Affiliate-Websites.

. Anwesenheit von 68 Sitemap: Eine Sitemap hilft Suchmaschinen-Index Ihrer Seiten einfacher und gründlicher, die Verbesserung der Sichtbarkeit.

69 Website-Uptime:. Viele Ausfallzeiten von Ort-Wartung oder Server-Probleme können Ihr Ranking zu verletzen (und kann sogar in Deindizieren führen, wenn nicht korrigiert).

. Server 70 Ort: Server-Standort kann beeinflussen, wo euer Ranking in verschiedenen geografischen Regionen. Besonders wichtig für Geo-Suche versuchen.

. SSL-Zertifikat 71 (E-Commerce-Seiten): Google hat bestätigt, dass sie Index-SSL-Zertifikate. Es liegt nahe, dass sie bevorzugt Rang Commerceseiten mit SSL-Zertifikaten.

72 Nutzungsbedingungen und Datenschutz Seiten:. Diese beiden Seiten helfen, sagen Google, dass eine Website ein vertrauenswürdiges Mitglied des Internets.

. Duplizieren 73 Meta Information vor Ort: Doppelte Meta-Informationen über Ihre Website möglicherweise zu Fall zu bringen alle die Sichtbarkeit Ihrer Seite ein.

74 Breadcrumb-Navigation:. Das ist ein Stil, der benutzerfreundliche Website-Architektur, die Benutzer (und Suchmaschinen) hilft, wo sie auf einer Website sind:

Sowohl SearchEngineJournal.com und ethische SEO Consulting behaupten, dass dieses Set-up kann ein Ranking-Faktor sein.

. Optimierte 75 Handy: Googles offizielle Haltung auf Mobil ist es, eine ansprechende Website zu erstellen. Es ist wahrscheinlich, dass ansprechende Seiten zu bekommen einen Vorteil bei der Suche von einem mobilen Gerät.

76 YouTube:. Es gibt keinen Zweifel, dass YouTube-Videos sind eine Vorzugsbehandlung in den SERPs (wahrscheinlich, weil Google es besitzt) gegeben:

In der Tat fand Search Engine Land, dass YouTube.com Verkehr deutlich erhöht, nachdem Google Panda.

77 Site Usability:. Eine Website, die schwierig zu bedienen oder zu navigieren kann durch die Verringerung der Zeit auf Website-Ranking schaden, aufgerufene Seiten und Bounce-Rate. Dies kann ein unabhängiger Faktor von algorithmischen massive Mengen von Benutzerdaten zu entnehmen.

. 78. Nutzung von Google Analytics und Google Webmaster Tools: Einige denken, dass mit diesen beiden Programmen auf Ihrer Website installiert ist, kann die Indizierung Ihrer Seite zu verbessern. Sie können auch unmittelbar beeinflussen, indem Rang Google mehr Daten mit (dh genauer Bounce-Rate, ob Sie bekommen referall Datenverkehr von Ihrem Backlinks etc.) zu arbeiten.

. Benutzerbewertungen 79 / Site Ruf: Eine Website ist zu der Bewertung Websites wie Yelp.com und RipOffReport.com spielen wahrscheinlich eine wichtige Rolle im Algorithmus. Google veröffentlicht sogar ein selten offen Umriss ihres Ansatzes Kommentare nach ein Brillen Seite wurde Abreißen Kunden in dem Bemühen um Backlinks zu erhalten gefangen.

Backlink Faktoren

. Linking 80 Domain Alter: Backlinks von alten Domänen können stärker als neue Domains sein.

# 81 von Linking Root-Domains:. Die Anzahl der Domains bezogen ist einer der wichtigsten Ranking-Faktoren in den Google-Algorithmus, da Sie von diesem Diagramm von Moz (untere Achse SERP-Position) sehen können:

# 82 von Links von Separate C-Klasse IPs:. Links von eigener Klasse-C-IP-Adressen deuten auf eine größere Breite der Seiten, die auf Sie.

# 83 von Linking Seiten:. Die Gesamtzahl der Verlinkung Seiten – auch wenn einige in der gleichen Domäne – ist ein Ranking-Faktor.

84 Alt-Tag (zur Bild-Links):. Alt Text ist eines Bildes Version von Anchor-Text.

85 Links von edu oder gov-Domains:… Matt Cutts hat erklärt, dass TLD nicht in einer Website Bedeutung berücksichtigen. Allerdings, die nicht aufhören SEOs vom Denken, dass es einen besonderen Platz in der Algo für. Gov und. Edu TLDs.

86 PR der verlinkenden Seite:. Der PageRank der verweisenden Seite ist ein extrem wichtiger Ranking-Faktor.

87 Behörde von Linking Domain:. Behörde des vorlegenden Domäne kann eine unabhängige Rolle in einer Verknüpfung Bedeutung (dh eine PR2 Seite Link von einer Website mit einer Homepage PR3 kann weniger als eine PR2 Seite Link von PR8 Yale.edu wert sein) zu spielen.

88 Links von Konkurrenten:. Links von anderen Seiten-Ranking in der gleichen SERP kann einer Seite Rang für die jeweilige Stichwort wertvoller sein.

89 Sozial Anteile der Bezug Seite:. Die Höhe der Seitenebene sozialen Aktien können den Wert der Verbindung zu beeinflussen.

90 Links von Bad Viertel:. Von „schlechte Nachbarschaft“ können Sie Ihre Website zu verletzen.

. 91. Gast Beiträge: Obwohl Gast Beitrag kann Teil eines weißen Hut SEO-Kampagne zu sein, verbindet die von Gastbeiträge – vor allem in einem Autor Bio-Bereich – nicht so wertvoll wie ein kontextuellen Link auf der gleichen Seite sein.

. 92 Links zu Homepage Domain, die Seite sitzt auf: Links auf die Homepage eines der verweisenden Seite kann eine besondere Bedeutung bei der Bewertung einer Website spielen – und damit eines Links – Gewicht.

. 93. Nofollow-Links: Einer der umstrittensten Themen in SEO. Google-Wort in der Sache ist:

„In der Regel wissen wir nicht folgen.“

Was nahelegt, dass sie tun … zumindest in bestimmten Fällen. Mit einer gewissen% des nofollow-Links kann auch auf einen natürlichen vs unnatürlich Link-Profil.

94 Vielfalt der Link-Typen:. Nachdem ein unnatürlich großer Prozentsatz Ihrer Links kommen aus einer Hand (dh Profile Forum, Blog-Kommentare) kann ein Zeichen von Webspam sein. Auf der anderen Seite, Links aus verschiedenen Quellen ist ein Zeichen von einer natürlichen Link-Profil.

. 95 „Sponsored Links“ oder andere Wörter Rund verlinken: Wörter wie „Sponsoren“, „Link-Partner“ und „sponsored links“ kann der Wert einer Link zu verringern.

. Kontextuelle 96 Links: Links innerhalb Inhalt einer Seite eingebettet werden als leistungsfähiger als Links auf einer leeren Seite oder an anderer Stelle auf der Seite.

. Übermäßige 97 301 Leitet zur Seite: Links aus 301-Weiterleitungen zu verdünnen einige (oder sogar alle) PR, entsprechend einer Webmaster-Hilfe Video.

98 Backlink Anchor Text:. Wie in dieser Beschreibung von Google ursprünglichen Algorithmus festgestellt:

„Erstens, verankert oft genauere Beschreibungen von Web-Seiten als die Seiten selber.“

Offensichtlich ist als Anchor-Text vor (und wahrscheinlich ein Webspam-Signal) weniger wichtig. Aber es ist noch ein deutliches Signal Relevanz in kleinen Dosen.

. 99. Interner Link Anchor Text: Interner Link Anchor-Text ist ein weiteres Signal Relevanz, wenn auch wahrscheinlich anders, als Backlink Anchor-Text gewogen.

. 100 Link-Titel Namensnennung: Der Link Titel (der Text, wenn Sie über einen Link zu schweben scheint) wird auch als schwache Relevanz Signale verwendet.

. 101 Land TLD der Bezug Domain: Erste Links von länderspezifischen Top-Level-Domain-Endungen (… De, cn, co.uk) kann Ihnen helfen, in diesem Land besser zu ordnen.

. 102 Link Lage In Content: Links im Anfang ein Stück Inhalt tragen leichte, mehr Gewicht als Links am Ende des Content platziert.

. 103 Link-Adresse auf Seite: wo auf einer Seite ein Link angezeigt wird, ist wichtig. Im Allgemeinen sind Links in den Inhalt einer Seite eingebettet stärker als Links im Footer oder Sidebar-Bereich.

104 Linking Relevanz Domain:. Ein Link von Website in einer ähnlichen Nische ist deutlich leistungsfähiger als ein Link von einem völlig anderen Ort. Das ist, warum jede wirksame SEO-Strategie heute konzentriert sich auf den Erhalt relevante Links.

Seite 105 Niveau Relevanz:. Die Hilltop-Algorithmus Staaten, die von einer Seite, die eng mit Content-Seite gebunden ist verlinkt ist mächtiger als ein Link von einem unabhängigen Seite.

. 106 Text um Link-Sentiment: Google hat wohl herausgefunden, ob ein Link zu Ihrer Website ist eine Empfehlung oder ein Teil einer negativen Bewertung. Links mit positiven Gefühlen um sie herum wahrscheinlich mehr Gewicht.

. 107 Stichwort im Titel: Google gibt extra Liebe zu Links auf Seiten, die Ihre Seite Keyword im Titel („Experten Anbindung an Experten“.)

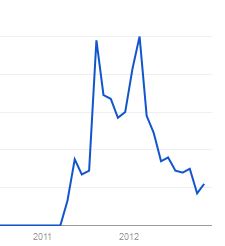

. 108 Positive Link-Geschwindigkeit: Eine Seite mit positiven Zusammenhang Geschwindigkeit wird in der Regel eine SERP Schub.

. 109 Negative Link-Geschwindigkeit: Negative Link Geschwindigkeit deutlich reduzieren kann Rankings, da es ein Signal mit abnehmender Popularität.

. 110 Von „Hub“ Seiten: Aaron Wall behauptet, dass immer Links von Seiten, die als Top-Ressourcen (oder Hubs) auf einem bestimmten Thema werden spezielle Behandlung.

. 111 Link von Authority Seiten: Ein Link von einer Website als eine „Behörde vor Ort“ wahrscheinlich passieren mehr Saft als ein Link von einer kleinen, microniche Ort.

112 Verbunden mit Wikipedia als Quelle:. Obwohl die Links nofollow, viele denken, dass immer einen Link von Wikipedia gibt Ihnen ein wenig hinzugefügt Vertrauen und Autorität in den Augen der Suchmaschinen.

113 Co-Vorkommen:. Die Worte, die rund um Ihre Backlinks erscheinen neigen hilft zu sagen, was das Google Seite geht.

114 Backlink Alter:. Laut einer Google-Patent, ältere Links Ranking haben mehr Macht als frisch gebackenen Backlinks.

. 115 Links von Echt Seiten vs Splogs: Aufgrund der Verbreitung von Blog-Netzwerke, Google gibt wahrscheinlich mehr Gewicht auf Links aus „echten Sites“ als von gefälschten Blogs. Sie verwenden wahrscheinlich Marke und Benutzerinteraktion Signale zwischen den beiden zu unterscheiden.

116 Natural Link Profil:. Eine Website mit einem „natürlichen“ Link-Profil wird zu hoch Rang und haltbarer sein, um Updates.

. 117 Reciprocal Links: Google-Link-Seite listet Schemes „Übermäßige Link Austausch“ als Link-Schema zu vermeiden.

. 118 User Generated Content Links: Google ist in der Lage, Links von UGC erzeugt im Vergleich zu den tatsächlichen Inhaber der Website zu identifizieren. Zum Beispiel wissen sie, dass ein Link von der offiziellen Blog auf WordPress.com en.blog.wordpress.com ist ganz anders als ein Link von besttoasterreviews.wordpress.com.

. 119 Links von 301: Links von 301-Weiterleitungen kann ein wenig Saft im Vergleich zu einem direkten Link zu verlieren. Allerdings, sagt Matt Cutts, dass ein 301 ist das ähnlich wie bei einem direkten Link.

. 120 Schema.org Microformats: Seiten, die Mikroformate unterstützen, können über Seiten ohne es Rang. Dies kann eine direkte Verstärkung oder die Tatsache, dass Seiten mit microformatting haben eine höhere SERP CTR sein:

. 121 DMOZ Eingestellt: Viele glauben, dass Google gibt DMOZ Websites ein wenig mehr Vertrauen.

. 122 Yahoo! Verzeichnis Eingestellt: Der Algorithmus könnte auch einen besonderen Platz für die Yahoo!-Verzeichnis, wenn man bedenkt, wie lange es wurde Katalogisierung Websites.

. 123 Anzahl ausgehender Links auf Seite: PageRank ist endlich. Ein Link auf eine Seite mit hunderten von OBLS geht weniger PR als eine Seite mit nur wenigen OBLS.

. 124 Forum Profil Links: Aufgrund der industriellen Ebene Spamming, kann Google deutlich abwerten Forum Links von Profilen.

. 125 Word Count Verknüpfung von Inhalt: Ein Link von einem 1000-Wort-Beitrag ist wertvoller als ein Link in einer 25-Wort-Schnipsel.

. 126 Qualität der Verknüpfung von Inhalt: Links von schlecht geschrieben oder Spinn Inhalt nicht so viel Wert zu übergeben, wie Links von gut geschrieben, Multimedia-Inhalte erweitert.

. 127 Sitewide Links: Matt Cutts hat bestätigt, dass sitewide Links sind „komprimiert“ als Single-Link zu zählen.

Benutzerinteraktion

. 128 Bio-Click Through Rate für ein Keyword: Seiten, die mehr in CTR geklickt bekommen kann eine SERP Schub für die jeweilige Stichwort zu bekommen.

. 129 Bio-CTR für Alle Keywords: Eine Seite (oder Website) organische CTR für alle Keywords ist für Reihen kann ein Mensch-basierte Benutzerinteraktionssignal sein.

. 130 Bounce Rate: Nicht jeder in SEO stimmt hüpfen Kursfragen, aber es kann ein Weg sein, um Google ihren Nutzern als Qualitätstester (Seiten, auf denen die Menschen schnell hüpfen ist wahrscheinlich nicht sehr gut) zu verwenden.

. 131 Direkt Traffic: Es ist bestätigt, dass Google Daten aus Google Chrome, um zu bestimmen, ob Menschen eine Website besuchen (und wie oft). Seiten mit vielen direkten Verkehr sind wahrscheinlich höhere Qualität als Websites, die nur sehr wenig direkten Verkehr.

. 132 Wiederholen Traffic: Sie können auch bei, ob Benutzer auf eine Seite oder Website nach dem Besuch gehen sehen. Seiten mit wiederkehrende Besucher können sich eine Google-Ranking zu steigern.

. 133 Blockierte Websites: Google hat diese Funktion in Chrome eingestellt. Allerdings verwendet Panda diese Funktion als Qualitätssignal.

134 Chrome Bookmarks:. Wir wissen, dass Google Chrome-Browser sammelt Nutzungsdaten. Seiten, die in Chrome Lesezeichen bekommen könnte einen Schub bekommen.

135 Google Toolbar Daten:. Search Engine Watch Danny Goodwin berichtet, dass Google Toolbar Daten als Ranking-Signal. Doch neben Seitenladegeschwindigkeit und Malware, es ist nicht, welche Art von Daten sie aus der Symbolleiste aufzulesen.

. 136 Anzahl der Kommentare: Seiten mit vielen Anmerkungen können ein Signal der Benutzer-Interaktion und Qualität sein.

137 Verweilzeit:. Google zahlt sehr genau auf „Verweilzeit“: wie lange verbringen die Menschen auf Ihre Seite, wenn man aus einer Google-Suche. Dies wird manchmal auch als „long Klicks vs kurze Klicks“ bezeichnet. Wenn die Menschen verbringen viel Zeit auf Ihrer Website, kann diese als Qualitätssignal verwendet werden.

Spezielle Regeln Algorithmus

. 138 Abfrage verdient Frische: Google gibt einen Schub neuer Seiten für bestimmte Suchanfragen.

. 139 Abfrage verdient Diversity: Google kann auf eine Vielfalt SERP für mehrdeutige Stichworte wie „Ted“, „WWF“ oder „ruby“ hinzuzufügen.

. 140 User-Browsing History: Websites, die Sie häufig besuchen, während in Google SERP unterzeichnet bekommen eine Beule für Ihre Suche.

. 141 Benutzersuche Geschichte: Suche Kette Einfluss Suchergebnisse für spätere Suchanfragen. Zum Beispiel, wenn Sie für „Bewertungen“, dann für „Toaster“ zu suchen zu suchen, Google ist eher in den SERPs Toaster review sites höher zu zeigen.

. 142 Geo-Targeting: Google Vorzug zu Seiten mit einem lokalen Server IP und länderspezifische Domain-Namen-Erweiterung.

. 143 Safe Search: Suchergebnisse mit Schimpfwörter oder Erwachsener Inhalt wird nicht für Menschen mit Safe Search erscheinen eingeschaltet.

. 144 Google+ Circles: Google zeigt höhere Ergebnisse für Autoren und Websites, die Sie haben, Ihre Google Plus Circles hinzugefügt

. 145 DMCA Beschwerden: Google „downranks“ Seiten mit DMCA-Beschwerden.

146 Domain-Vielfalt:. Die so genannte „Bigfoot Update“ angeblich zu jeder Seite hinzugefügt SERP mehr Domains.

. 147 Transactional Suchen: Google zeigt manchmal unterschiedliche Ergebnisse für Shopping-verwandte Keywords, wie Flugsuchen .

. 148 Lokale Suchen: Google legt oft Google+ Lokale Ergebnisse über dem „normalen“ organischen SERPs.

149 Google News Box:. Bestimmte Stichworte, lösen eine Google News Feld:

. 150 große Marken-Vorlieben: Nach dem Vince Update, begann Google geben große Marken einen Schub für bestimmte Short-Tail-Suchanfragen.

. 151 Einkaufs Ergebnisse: Google manchmal zeigt Google Shopping Ergebnisse in organischen SERPs.

. 152 Ergebnisse Bilder: Google Ellenbogen unserem Bio-Angebote für Bildergebnisse für die Suche häufig auf Google-Bildsuche verwendet.

. 153 Easter Egg Ergebnisse: Google hat ein Dutzend oder so Osterei Ergebnisse. Zum Beispiel, wenn Sie für „Atari Breakout“ in Google-Bildersuche zu suchen, drehen Sie die Suchergebnisse in ein spielbares Spiel (!). Shout Out an Victor Pan für diese ein.

. 154 Einzel Ergebnisse für Marken-Site: Domain oder markenorientierten Keywords bringen einige Ergebnisse aus dem gleichen Ort.

Soziale Signale

. 155 Anzahl der Tweets: Wie Links, Tweets die eine Seite hat, kann seinen Rang in Google beeinflussen.

. 156 Behörde der Twitter-Nutzer-Konten: Es ist wahrscheinlich, dass die Tweets, die von Alter, Autorität Twitter-Profile mit einer Tonne von Anhängern (wie Justin Bieber) haben mehr Wirkung als Tweets von neuen, preis Einfluss Konten.

. 157 Anzahl der Facebook-Likes: Obwohl Google nicht sehen können, die meisten Facebook-Konten, ist es wahrscheinlich, dass sie prüfen, die Zahl der Facebook mag eine Seite erhält als schwache Ranking-Signal.

. 158 Facebook-Aktien: Facebook-Aktien – weil sie mehr Ähnlichkeit mit einem Backlink – kann einen stärkeren Einfluss als Facebook haben mag.

. 159 Behörde von Facebook-Benutzerkonten: Wie bei Twitter, Facebook Aktien und mag aus beliebten Facebook-Seiten kann mehr Gewicht geben.

. 160 Pinterest Pins: Pinterest ist eine wahnsinnig beliebte Social-Media-Account mit vielen öffentlichen Daten. Es ist wahrscheinlich, dass Google hält Pinterest Pins ein soziales Signal.

. 161 Stimmen auf Social-Sharing-Sites: Es ist möglich, dass Google-Aktien auf Seiten wie Reddit, StumbleUpon und Digg als eine andere Art von Social Signals.

. 162 Anzahl der Google+ 1 ist: Auch wenn Matt Cutts auf der Platte mit den Worten Google+ hat „keine direkten Auswirkungen“ auf Rankings gegangen, ist es schwer zu glauben, dass sie würden ihre eigenen sozialen Netzwerk zu ignorieren.

. 163 Behörde von Google+ Benutzerkonten: Es ist logisch, dass Google +1′ s wiegen maßgebliche Konten kommen mehr als von den Konten ohne viele Anhänger.

164 Verifizierte Google+ Autor:. Im Februar 2013 Google-CEO Eric Schmidt bekanntlich behauptet:

„Innerhalb von Suchergebnissen, Informationen zu überprüften Online-Profile gebunden wird höher sein als Inhalt auf Platz ohne eine solche Überprüfung werden, was die meisten Nutzer natürlich Sie auf den oberen (überprüft) Ergebnisse führen wird.“

Verifizierte Urheber bereits eine Vertrauenssignal sein.

165 Sozial Signal Relevanz:. Google wahrscheinlich verwendet Relevanz Informationen vom Konto teilen den Inhalt und den Text den Link umgibt.

166 Standortebene Soziale Signale:. Website-weiten sozialen Signale Gesamtverantwortung einer Website zu erhöhen, welche Such Sichtbarkeit für alle Seiten erhöhen.

Marke Signale

. 167 Markenname Anchor Text: Branded Anchor-Text ist eine einfache – aber starke – Marke Signal.

. 168 Branded Suchen: Ganz einfach: die Leute suchen für Marken. Wenn die Leute suchen für Ihre Website in Google (zB „Backlinko twitter“, Backlinko + „-Ranking-Faktoren“), wahrscheinlich nimmt Google dies bei der Bestimmung einer Marke.

. 169 Seite hat Facebook-Seite und Stimmen: Marken neigen dazu, Facebook-Seiten mit vielen Leuten zu haben.

. 170 Website hat Twitter Profil mit Anhänger: Twitter-Profile mit einer Menge von Anhängern signalisiert eine beliebte Marke.

171 Amts Linkedin Company Seite:. Die meisten Unternehmen haben echte Firma Linkedin Seiten.

. 172 Mitarbeiter Gelistet bei Linkedin: Rand Fishkin denkt, dass mit Linkedin-Profile, die sie für Ihr Unternehmen arbeiten, sagen, ist eine Marke Signal.

. 173 Legitimität der Social Media-Konten: Ein Social-Media-Account mit 10.000 Anhängern und 2 Beiträge wahrscheinlich interpretiert viel anders als eine andere 10.000 Follower starken Konto mit viel Interaktion.

. 174 Marke Erwähnungen in News Seiten: Wirklich große Marken bekommen auf Google News Seiten erwähnt die ganze Zeit. In der Tat, einige Marken haben sogar ihre eigene Google News-Feed auf der ersten Seite.

175 Co-Citations:. Marken zu bekommen, ohne sich zu verlinkenden erwähnt. Google sieht wahrscheinlich nicht erwähnt Hyperlink Marke als Marke-Signal.

. 176 Anzahl der RSS Abonnenten: Bedenkt man, dass Google besitzt das beliebte Feedburner RSS-Service, macht es Sinn, dass sie bei RSS Teilnehmerdaten wie eine Beliebtheits / Marke Signal zu suchen.

. 177 Brick and Mortar Lage Mit Google+ Local Listing: Echt Unternehmen haben Büros. Es ist möglich, dass Google Fische für Standort-Daten, um zu ermitteln, ob eine Website ist eine große Marke.

. 178 Webseite ist Steuerzahl Geschäft: Moz berichtet, dass Google an, ob eine Website mit einem steuerzahlenden Unternehmen verbunden sehen.

On-Site-Webspam Faktoren

. 179 Panda Elfmeter: Seiten mit Low-Qualität der Inhalte (insbesondere Inhalte Farmen) sind weniger sichtbar auf der Suche nach immer von einem Panda Strafe getroffen.

. 180 Links zu schlechte Nachbarschaften: Verknüpfung aus, um „schlechte Nachbarschaft“ – wie Apotheke oder Zahltag Darlehen Websites – können die Suche Sichtbarkeit zu verletzen.

. 181 Redirects: Sneaky leitet ist ein großes no-no. Wenn gefangen, kann es eine Website nicht nur bestraft, aber de-indiziert.

. 182 Popups oder störende Anzeigen: Die offizielle Google Rater Richtlinien Dokument sagt, dass störende Popups und Anzeigen ist ein Zeichen für eine niedrige Qualität Ort.

183. Site Over-Optimization: Includes on-page factors like keyword stuffing, header tag stuffing, excessive keyword decoration.

184. Page Over-Optimizaton: Many people report that — unlike Panda — Penguin targets individual page (and even then just for certain keywords).

185. Ads Above the Fold: The „Page Layout Algorithm“ penalizes sites with lots of ads (and not much content) above the fold.

186. Hiding Affiliate Links: Going too far when trying to hide affiliate links (especially with cloaking) can bring on a penalty.

187. Affiliate Sites: It’s no secret that Google isn’t the biggest fan of affiliates. And many think that sites that monetize with affiliate links are put under extra scrutiny.

188. Autogenerated Content: Google isn’t a big fan of autogenerated content. If they suspect that your site’s pumping out computer-generated content, it could result in a penalty or de-indexing.

189. Excess PageRank Sculpting: Going too far with PageRank sculpting — by nofollowing all outbound links or most internal links — may be a sign of gaming the system.

190. IP Address Flagged as Spam: If your server’s IP address is flagged for spam, it may hurt all of the sites on that server.

191. Meta Tag Spamming: Keyword stuffing can also happen in meta tags. If Google thinks you’re adding keywords to your meta tags to game the algo, they may hit your site.

Off Page Webspam Factors

192. Unnatural Influx of Links: A sudden (and unnatural) influx of links is a sure-fire sign of phony links.

193. Penguin Penalty: Sites that were hit by Google Penguin are significantly less visible in search.

194. Link Profile with High % of Low Quality Links: Lots of links from sources commonly used by black hat SEOs (like blog comments and forum profiles) may be a sign of gaming the system.

195. Linking Domain Relevancy: The famous analysis by MicroSiteMasters.com found that sites with an unnaturally high amount of links from unrelated sites were more susceptible to Penguin.

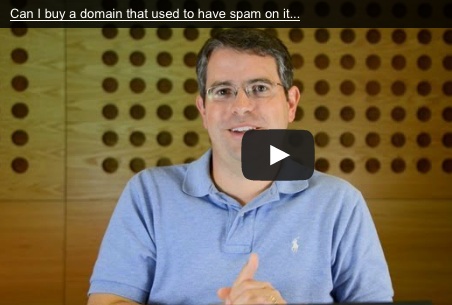

196. Unnatural Links Warning: Google sent out thousands of „Google Webmaster Tools notice of detected unnatural links“ messages. This usually precedes a ranking drop, although not 100% of the time.

197. Links from the Same Class C IP: Getting an unnatural amount of links from sites on the same server IP may be a sign of blog network link building.

198. „Poison“ Anchor Text: Having „poison“ anchor text (especially pharmacy keywords) pointed to your site may be a sign of spam or a hacked site. Either way, it can hurt your site’s ranking.

199. Manual Penalty: Google has been known to hand out manual penalties, like in the well-publicized Interflora fiasco.

200. Selling Links: Selling links can definitely impact toolbar PageRank and may hurt your search visibility.

201. Google Sandbox: New sites that get a sudden influx of links are sometimes put in the Google Sandbox, which temporarily limits search visibility.

202. Google Dance: The Google Dance can temporarily shake up rankings. According to a Google Patent, this may be a way for them to determine whether or not a site is trying to game the algorithm.

203. Disavow Tool: Use of the Disavow Tool may remove a manual or algorithmic penalty for sites that were the victims of negative SEO.

204. Reconsideration Request: A successful reconsideration request can lift a penalty.